Comment les lettres apparaissent-elles à l’écran ? Comment lisons-nous les caractères, ces délicieuses expressions du design, tellement singulières que nous distinguons instantanément le Baskerville du Caslon ou du Comic Sans ? […] L’évolution des supports, de la gravure lapidaire aux écrans en passant par les surfaces encrées, a influencé notre conception des lettres. […] Mais que sont-elles ? Nos ancêtres se sont-ils posé cette question en élaborant leurs glyphes proto-cananéens, au début du second millénaire avant J.-C., lorsque l’alphabet émergea de la rencontre des écritures cunéiformes et des hiéroglyphes ? Si c’est le cas, il ne reste rien de ces possibles questionnements. Les premières traces écrites traitant des origines et de l’identité des lettres proviennent des Grecs, près de mille ans plus tard. […] Ces derniers avaient conscience des disparités entre typologies et systèmes de signes : s’étant rendu en Égypte pour étudier les signes pictographiques et le mythe de la mimesis, Platon, dans Le Cratyle, colporte l’idée évidemment erronée que les hiéroglyphes sont spontanément intelligibles. […]

L’alphabet n’a pas été inventé, mais a émergé […] d’une même racine dans les contrées de Canaan, Akkad, Moab, Byblos, et du Sinaï ; des noms qui jalonnent l’histoire religieuse du Moyen-Orient — du croissant fertile de Mésopotamie en passant par le Maghreb11 Seth Sanders, The Invention of Hebrew, Urbana, University of Illinois Press, 2009.. Les inscriptions fragmentaires laissées par ces peuples témoignent des premières apparitions d’un système de signes qui n’était ni cunéiforme, ni hiéroglyphique, ni syllabique, ni logographique, ni idéographique, mais alphabétique (où les lettres représentent des phonèmes). […]

Mais la question qui guide notre recherche sur le paradoxe des lettres à l’écran ; la tension entre l’existence unique (« atomisée ») et systémique de ces formes — reste la même depuis des siècles : non pas simplement « Qu’est-ce que l’alphabet ? », mais plutôt « Comment l’alphabet opère-t-il suivant la manière dont nous le concevons ? » […] Les réponses à ces questions résonnent avec notre situation contemporaine, celle de l’emprise hégémonique, impensée, de l’alphabet occidental sur le traitement informatique et l’infiltration des systèmes ASCII, Unicode et BinHex jusque dans la structure même du monde connecté. […]

Les implications de l’évolution des moyens de production sur le design peuvent être étudiées en observant la carrière d’un designer comme Matthew Carter. Après avoir commencé sa formation avec son père par la gravure lapidaire et la calligraphie, il s’empare pleinement de chaque évolution technique ; plomb, photocomposition, numérique —, depuis les premières bouillies de pixels jusqu’aux polices programmables (polices variables)  , dont les variantes aléatoires sont calculées par des algorithmes22 Margaret Re, Typographically Speaking: The Art of Matthew Carter, New York, Princeton Architectural Press, 2003.. Sa pratique l’a sensibilisé aux problématiques d’échelle et au besoin de compenser la façon dont la lumière se propage à travers un négatif, et bouche les fines jonctions des lettres entre fûts, jambages et empattements. Pour corriger ces altérations, le dessinateur de caractères devait ciseler chaque détail à échelle microscopique, afin que la lumière ne transforme pas la matrice initiale en masses grossières

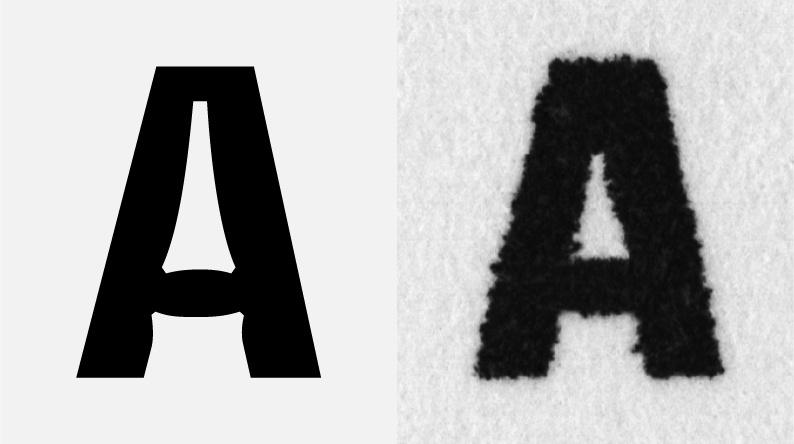

, dont les variantes aléatoires sont calculées par des algorithmes22 Margaret Re, Typographically Speaking: The Art of Matthew Carter, New York, Princeton Architectural Press, 2003.. Sa pratique l’a sensibilisé aux problématiques d’échelle et au besoin de compenser la façon dont la lumière se propage à travers un négatif, et bouche les fines jonctions des lettres entre fûts, jambages et empattements. Pour corriger ces altérations, le dessinateur de caractères devait ciseler chaque détail à échelle microscopique, afin que la lumière ne transforme pas la matrice initiale en masses grossières  . Rétrospectivement, au regard des caractères numériques contemporains stockés, latents, en attente d’une requête d’affichage ou d’impression, la photocomposition semble assez directe et, finalement, peu influencée par son médium. […]

. Rétrospectivement, au regard des caractères numériques contemporains stockés, latents, en attente d’une requête d’affichage ou d’impression, la photocomposition semble assez directe et, finalement, peu influencée par son médium. […]

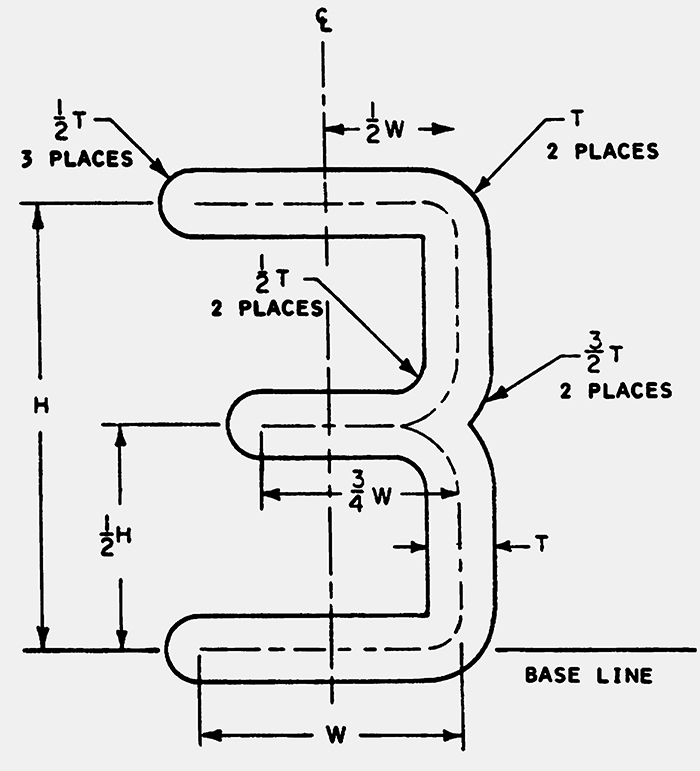

Mais que dessiner ? Le problème est complexe : même s’il est difficile de graver des lettres dans la pierre, l’inscription est immédiate. À l’inverse, un fichier numérique de description typographique ; l’ensemble des instructions destinées à tracer une forme prédéfinie — intercale un certain nombre de procédés techniques dans le processus de conception. Les caractères bitmap peuvent être ajustés manuellement, dans les fichiers sources, pour que les emplacements des pixels soient définis pour chaque corps d’affichage. […] Les polices outline (dont la forme est décrite par le contour) sont, quant à elles, stockées sous la forme d’un ensemble d’instructions décrivant la forme extérieure de la lettre. […] Au départ, il existait une distinction entre les caractères pour écran et les polices pour imprimantes, ces dernières utilisant des fichiers spécifiques destinés à communiquer des données graphiques. L’avènement des imprimantes laser [Apple LaserWriter, 1985] a permis d’affiner les productions graphiques, demandant alors plus de puissance de calcul et de mémoire. Il fallait tenir compte de l’existence distribuée des polices, divisées entre l’affichage écran et l’impression papier ; ce qui soulève alors des questions d’ontologie et d’identité.

Le cycle de vie des polices numériques (conception, stockage, traitement, affichage, impression) se déroulait au sein d’environnements aux besoins et aux protocoles différents. Les premiers dispositifs d’impression étaient rudimentaires : les tables traçantes (plotter) et imprimantes matricielles produisaient des lettres grossières dont les mouchetures tramées évoquent vaguement l’impression au plomb. Les lettres pixelisées et scintillantes des premiers écrans monochromes orangés ou verts étaient aussi élégantes qu’une carte perforée et aussi raffinées que le point de croix. […] Mais comment ces lettres numériques sont-elles produites ? Qu’est-ce qui est stocké, où et comment ? L’illusion de caractères discrets, stables ou possédant une autonomie « atomiste » explose avec les polices numériques. Même au niveau de leur singularité graphique, les lettres n’existent qu’en se distinguant les unes des autres, et non pas comme des formes visuelles autonomes.

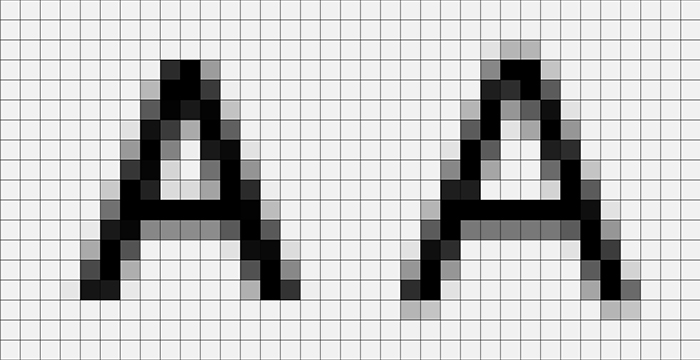

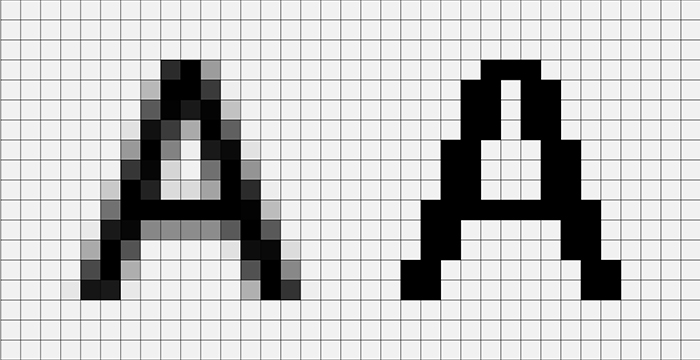

Le dessin de caractères sur ordinateur personnel commence à prendre forme au milieu des années 1980, bien avant que les polices ne circulent en ligne. Le problème fondamental consiste alors à créer l’illusion de courbes dans un monde de pixels, forçant les designers à choisir entre graphisme vectoriel et images matricielles. Les courbes de Bézier permettent de dessiner des transitions progressives du plein au délié, des formes bombées et des jonctions soignées, mais exigeaient beaucoup de ressources machine. […]

Le choix de ce qu’il faut stocker ; les contours d’un glyphe (courbes et points) ou un motif de pixels — a des conséquences sur chaque étape de vie de la police. Le format de fichier TrueType [1991], un procédé inventé par Apple pour stocker les polices définies par leurs contours, a été conçu pour concurrencer les polices Adobe Type 133 « Fonte PostScript », Wikipédia, http://b-o.fr/postscript_fr (N.D.É.) utilisées dans le langage de description de pages PostScript [1982]. Le grand avantage des polices TrueType et Type 1 d’Adobe est leur aspect évolutif ; le même dessin peut être réadapté à n’importe quelle taille, du moins en apparence44 Thomas Phinney, « TrueType and Post ScriptType 1: What’s the Difference? », Truetype Typography, 2011, http://b-o.fr/truetype. Des expériences avec des polices Multiple Master [MM] comme le Minion [1990] ont (brièvement) joué avec la capacité de l’ordinateur à interpoler des formes de lettres à travers un ensemble de variables. Chaque corps doit être retravaillé pour optimiser son affichage à l’écran, c’est ce qu’on appelle l’optimisation de rendu (hinting)  . La question de savoir où et comment vit un langage d’impression ; qu’il fasse partie d’un système d’exploitation (OS), d’applications ou de logiciels associés à des imprimantes spécifiques — a des répercussions commerciales, chaque appareil devant être capable de lire les différents formats de fichiers afin d’afficher correctement les lettres. S’accordant sur un standard unique pour normer les formats des polices numériques, Microsoft et Apple ont collaboré sur TrueType au début des années 1990.

. La question de savoir où et comment vit un langage d’impression ; qu’il fasse partie d’un système d’exploitation (OS), d’applications ou de logiciels associés à des imprimantes spécifiques — a des répercussions commerciales, chaque appareil devant être capable de lire les différents formats de fichiers afin d’afficher correctement les lettres. S’accordant sur un standard unique pour normer les formats des polices numériques, Microsoft et Apple ont collaboré sur TrueType au début des années 1990.

Les fichiers de caractères numériques, comprenant des éléments de dessin, d’affichage bitmap et d’impression, étaient originellement envoyés sur disquette par la poste. Ils étaient volumineux et prenaient beaucoup de place sur le disque dur. L’affichage à l’écran relevait également du défi : aussi contre-intuitif que cela puisse paraître, flouter l’affichage monochrome d’une lettre par un mécanisme d’anti-crénelage  (antialiasing) tire parti de la capacité de l’œil à donner l’impression d’une forme plus nette55 « Font rasterization » (matricialisation de caractères), Wikipédia, http://b-o.fr/rasterization (N.D.É). De près, l’anti-crénelage paraît brouillé et flou, tandis qu’à une distance de lecture normale, les lettres semblent plus fines sur la plupart des écrans que leurs homologues bitmap, d’un contraste pourtant supérieur. […] Ces défis techniques ne concernent que les ingénieurs et designers, et non les philosophes. […] Les typographes parlent de character drift (dérapage de caractère) lorsqu’ils évoquent le hinting et pose un problème d’identification sur une lettre en dépassant du cadre qui lui est alloué. Un « r » minuscule peut rapidement se transformer en « i » dont le point a glissé. Qu’est-ce qu’une lettre, dans ces conditions ? Où réside son identité ? Comment cette identité est-elle spécifiée ? […]

(antialiasing) tire parti de la capacité de l’œil à donner l’impression d’une forme plus nette55 « Font rasterization » (matricialisation de caractères), Wikipédia, http://b-o.fr/rasterization (N.D.É). De près, l’anti-crénelage paraît brouillé et flou, tandis qu’à une distance de lecture normale, les lettres semblent plus fines sur la plupart des écrans que leurs homologues bitmap, d’un contraste pourtant supérieur. […] Ces défis techniques ne concernent que les ingénieurs et designers, et non les philosophes. […] Les typographes parlent de character drift (dérapage de caractère) lorsqu’ils évoquent le hinting et pose un problème d’identification sur une lettre en dépassant du cadre qui lui est alloué. Un « r » minuscule peut rapidement se transformer en « i » dont le point a glissé. Qu’est-ce qu’une lettre, dans ces conditions ? Où réside son identité ? Comment cette identité est-elle spécifiée ? […]

Les polices de caractères web-safe sont liées à la capacité des navigateurs Web à accéder aux informations stockées dans le système d’exploitation. Les fichiers de polices doivent être chargés, tramés, « hintés » et configurés par le navigateur, traduisant ainsi les informations d’une page Web à l’aide de polices stockées localement et des capacités d’affichage de la machine. Si une police inconnue est référencée dans un fichier HTML, le navigateur Web utilise une police « par défaut » du système d’exploitation du bureau. À l’origine, le langage HTML [1993] n’avait pas la capacité d’intégrer des polices spécifiques ; elles étaient contrôlées par le navigateur. Chaque navigateur avait ses propres limitations et spécifications. Les concepteurs de sites Web étaient consternés : le HTML, conçu pour « l’affichage » écran, avait supprimé l’un des éléments fondamentaux de la conception graphique : les polices de caractères. La grossièreté de la gestion des titres du système HTML (balises <h1>, <h2>, etc.) ; qui prenait uniquement en compte les corps relatifs des quelques polices disponibles pour les pages Web (web-safe) — était extrêmement réductrice, mais très puissante. En ignorant l’information requise pour la description des polices, le HTML pouvait se concentrer sur d’autres aspects de l’affichage à une époque où la bande passante était lente et où les navigateurs étaient encore limités techniquement. C’était comme forcer un pianiste de concert d’envergure internationale à jouer du Rachmaninov sur un jouet pour enfant d’une douzaine de touches. En 1995, Netscape introduit la balise <font>, destinée à afficher une police spécifique à condition que cette dernière soit installée sur la machine de l’utilisateur. Sinon, une série d’instructions permet de revenir aux polices « par défaut ».

Par la suite, les premières feuilles de style CSS [1996] ne permirent de spécifier que cinq caractéristiques des polices à afficher pour un élément donné : famille (avec ou sans empattements, monochasse, cursive, fantaisie), style, variante, graisse et taille […] : les subtilités graphiques de l’imprimé disparurent. […] Les concepteurs de sites Web, déjà ennuyés par l’approximation non sémantique du code HTML, virent leur Gill Sans se transformer en Arial, et leur Hoefler Text ou Mrs. Eaves en Times New Roman.

La solution la plus récente, le format Web Open File Format [WOFF, 2012], transfère la responsabilité du stockage des polices sur un serveur à partir duquel l’information peut être appelée. […] Ce dernier suppose une connexion permanente à Internet pour que chaque instance soit bien affichée à partir des fichiers fournis lors d’une requête. La complexité de ces fichiers ; adaptés à la variété des navigateurs, écrans, et périphériques de sortie, y compris des imprimantes — s’explique par de la nécessité de coordonner la cohérence de l’unité de la police à chaque étape de sa conception, stockage, transfert, traitement, appel en mémoire, affichage, sortie, etc. La notion de « matérialité distribuée », développée par Jean-François Blanchette66 Jean-François Blanchette, « A Material History of Bits », Journal of the American Association for Information Science and Technology, vol. 62, no 6, 2011, p. 1042-1057., donne une bonne idée des relations interdépendantes de mémoire, de traitement, de stockage, de réseaux et autres caractéristiques de l’appareil informatique mises en jeu lorsque l’existence d’une lettre est distribuée et contingente.

Une lettre ? Imaginez des lignes de code, les forks [versions alternatives] et les paramètres intégrés aux coulisses et à l’affichage de chaque glyphe. L’habileté du graveur de poinçons, si inspirante par sa précision manuelle et sa délicate exécution, s’accompagne désormais d’un ensemble d’instructions, tout aussi remarquables, mais presque invisibles (après tout, le code source peut être lu, bien qu’il soit rarement affiché tel quel). Elles encodent également la propriété ou la mention de la fonderie et, pourquoi pas à l’avenir, un ensemble de signaux destinés à déclencher des micropaiements en fonction du nombre de visites du site Web. La lettre est désormais à la fois un modèle économique distribué, et une forme graphique intégrant ses propres caractéristiques d’identification. Elle s’acquitte de tous ses rôles et activités, se conformant aux normes et protocoles du Web. Elle se doit de vivre sur un serveur, sans se corrompre ni se décomposer, et de s’exécuter sur commande. Les lettres sont devenues des mégafichiers intégrant des métadonnées, enveloppés d’instructions comportementales et formelles. De nos jours, le stockage des polices renforce la dimension performative de son unicité : un fichier est une multitude de possibles en attente d’instanciation77 Johanna Drucker, « From Entity to Event: From Literal Mechanistic Materiality to Probabilistic Materiality », Parallax, vol. 15, no 4, 2009, p. 7-17.. […]

Si une lettre est une entité unique et qu’elle peut rester indépendante de sa mise en œuvre, qu’est-ce que cela signifie88 Mason Glaves, « The Impending Implementation Independent Interface », 2006, http://b-o.fr/glaves ? L’expression d’« implémentation indépendante » me rappelle un moment, il y a quelques années, où un jeune universitaire en poésie moderne intéressé par la typographie et le design éditorial me demandait : « Une lettre a-t-elle un corps [body] ? En a-t-elle besoin ? » Je n’avais jamais réfléchi à la question de cette façon. Où chercher une réponse à cette métaphysique de la forme ? Dans son essai sur les origines de la géométrie, [le philosophe] Edmund Husserl explore la relation entre le « premier géomètre » et les triangles idéaux (et autres formes géométriques), dont il propose de considérer l’existence comme indépendante de la perception humaine, alors même qu’ils sont issus des systèmes constitutifs de pensée représentationnelle99 Edmund Husserl, L’origine de la géométrie [1936], trad. de l’allemand par Jacques Derrida, Paris, Puf, 1962.. Mais les lettres ne sont pas comme des triangles. Leurs proportions et leur harmonie ne sont ni absolues ni parfaites, et ne peuvent pas être exprimées en formules abstraites. L’espace entre l’incarnation formelle des lettres et leurs formes prescrites mathématiquement ; se conformant à des équations universellement vraies — laisse entrevoir le chemin qui mène du « A » à l’écran. Car si tous les cercles peuvent être créés selon les mêmes règles (centre, rayon, circonférence), les lettres ne peuvent pas être prescrites de la même manière. La notion même de « pré-scription », d’écriture préalable, a de fait une résonance philosophique.

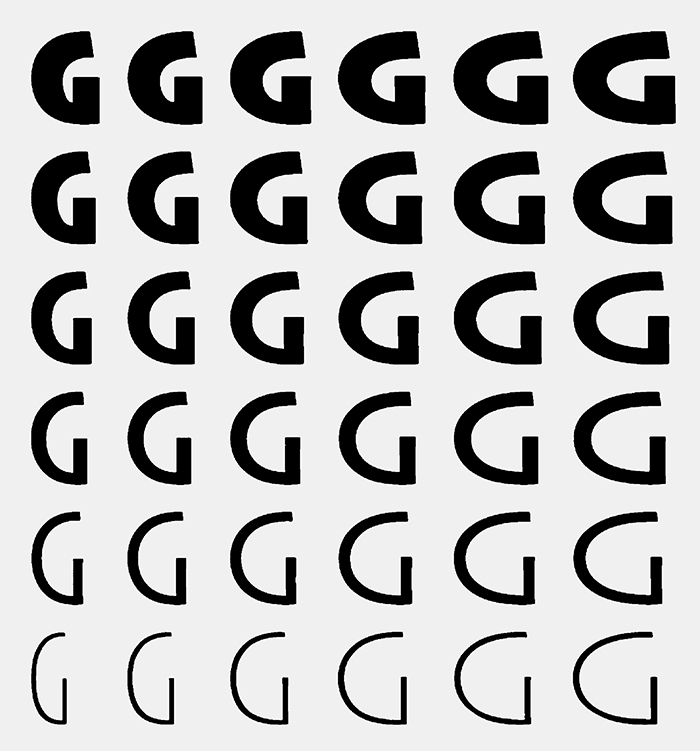

Les travaux de Donald Knuth à la fin des années 19701010 Donald Knuth, Metafont: the Program, Reading (MA.), Addison-Wesley, 1986. ont introduit des enjeux métaphysiques à l’approche pratique de ce problème. Ce mathématicien et pionnier de la programmation informatique travaillait sur l’identité algorithmique des lettres. Son échec à modéliser les lettres fut pour lui un révélateur de leur complexité graphique. À la fin des années 1970, frustré par les coûts de publication qu’impliquait la production de ses livres, Knuth voulut utiliser un ordinateur et des caractères générés pour la composition de ses publications. En 1982, il imagine une « méta-police » (metafont) permettant de tirer parti des capacités des médias numériques afin de générer des formes de lettres et des équations visuelles. Pour ses programmes de composition et de mise en pages TeX et METAFONT, il postule qu’un seul ensemble d’algorithmes suffit pour décrire les lettres alphabétiques de base. Comme l’énoncera plus tard [le chercheur] Douglas Hofstadter, Knuth offre ici une « perspective alléchante : grâce aux ordinateurs, nous pouvons désormais entrevoir la possibilité d’unifier toutes les polices de caractères1111 Douglas Hofstadter, « Metafont, Meta-mathematics, and Metaphysics », Metamagical Themas, New York, Viking, 1985, p. 266.. » […]

La manière dont Knuth envisage les lettres dépend entièrement de la technologie de construction qu’il utilise pour leur donner forme. Il traite les lettres comme des informations mathématiques pures, et suggère ainsi leur possible réduction algorithmique, en dehors de toute formalisation. Il affirme que les lettres n’ont pas besoin d’un corps, ce qui démontre une nouvelle fois que les technologies et le contexte technique contribuent à construire notre compréhension de la notion de lettre. Cet exemple singulier va à l’encontre de tout déterminisme technologique du dessin de caractères. Une lettre est ainsi toujours définie par un mélange fluctuant, combinant possibilités matérielles et idée abstraite. […]

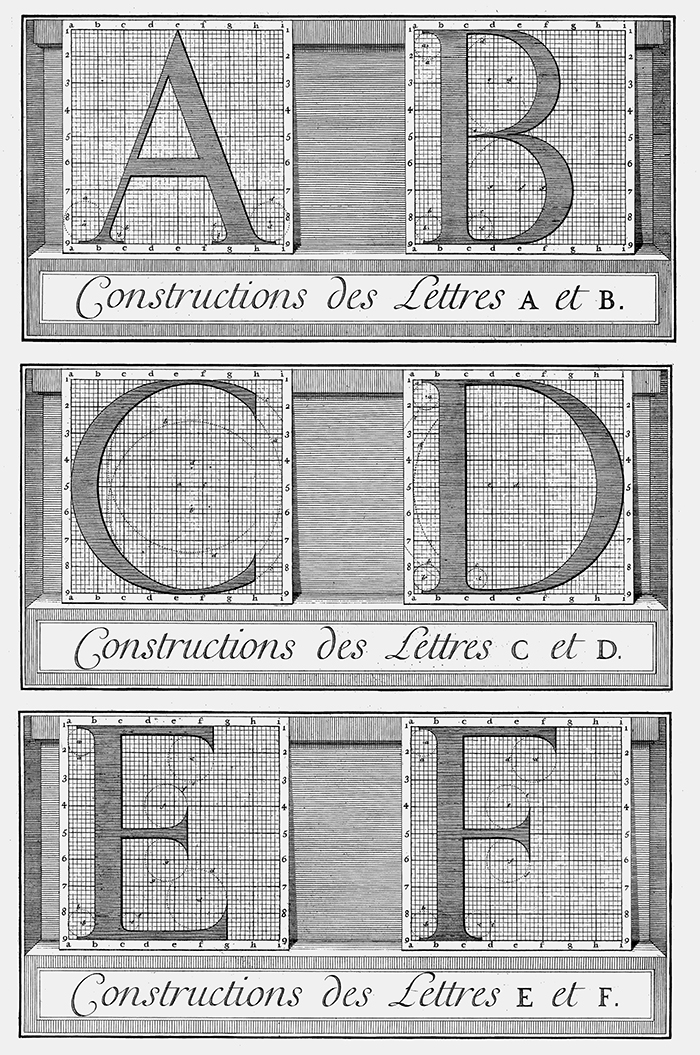

L’hyper-rationalisation de la typographie n’est pas, pour autant, le propre des technologies numériques, et les approches du dessin de caractères comme des systèmes élaborés ont plusieurs précédents notables. Les typographes de la Renaissance comme Giambattista Palatino, Giovanni Tagliente et Luca Pacioli1212 Stanley Morison, Fra Luca de Pacioli, New York, Grolier Club, 1933., imaginaient déjà une continuité depuis les majuscules romaines classiques. Ils s’efforçaient ainsi d’imiter la perfection des formes et des proportions des inscriptions géantes du forum [place romaine] afin de créer un système destiné à incarner des principes rationnels pour le dessin de leurs caractères1313 Bruce Rogers, Paragraphs on Printing, New York, Dover Reprint, 1979.. Les lettres de la colonne Trajane, érigée en 113 après J.-C., constituaient alors (et constituent toujours aujourd’hui) un exemple remarquable de la typographie romaine. Les formes et leur inscription transmettent un sentiment d’ordre et de beauté en équilibre, une sorte de majesté forte, à la fois impériale, classique et humaine. Le mythe du dessin romain au compas et à la règle a persisté jusqu’au XXe siècle, lorsque l’observation attentive du père Edward Catich1414 Edward M. Catich, The Origin of the Serif: Brush Writing and Roman Letters, Davenport, Catfish Press, 1968. montra que les détails de la forme sont trop subtils pour être tracés avec des instruments mécaniques1515 James Clough, « James Clough’s Roman Letter », 2011, http://b-o.fr/clough. […] D’après l’Encyclopedia Romana [1898–1904], Catich « fait l’hypothèse que les formes étaient d’abord esquissées en trois ou quatre gestes rapides avec un pinceau plat à sortie carrée, produisant ainsi des variations de graisse caractéristiques en fonction de l’orientation de la brosse. Les lettres étaient ensuite gravées par la même personne (et non par un scribe et un tailleur de pierre comme l’affirmait Catich), l’ombre projetée dans le relief donnant l’illusion de la forme1616 « Trajan’s Column » (La colonne Trajane), http://b-o.fr/trajane. » […]

Malgré tout, les artistes de la Renaissance s’efforçaient de créer des formes parfaites à partir d’observations de vestiges antiques. Leur vision du monde, décrite par des tracés idéaux traduisant l’expression d’une croyance cosmologique dans la perfection de la proportion divine, dépendait de cercles et de carrés réguliers. Dans De Divina Proportione, Pacioli projette ainsi les mêmes caractéristiques graphiques sur les diagrammes de [l’astronome] Tycho Brahe et son explication du mouvement apparent des planètes. Pour eux, caractères et cosmos sont l’expression d’une conception divine, et doivent donc être issus de formes parfaites. Avec le recul, les cercles inscrits, méticuleusement construits par Tycho Brahe pour décrire des mouvements elliptiques, sont aussi aberrants dans leurs principes mathématiques que les tentatives de tracés géométriques des lettres capitales de Pacioli1717 Arthur Koestler, Les somnambules, trad. de l’anglais par Georges Fradier, Paris, Calmann-Lévy, 1960..

Une autre tentative de rationalisation extrême, reposant sur de savants calculs, fut menée au tout début du XVIIe siècle sur ordre de Louis XIV. Le Romain du Roi  qui en résulta, régi par sa grille de carrés parfaits et approuvé par un grand comité de spécialistes, s’avéra stérile et statique à l’œil. Pris en charge par le graveur de poinçons Philippe Grandjean, les dessins abstraits du caractère royal, à l’usage exclusif de la monarchie, furent subtilement modifiés durant le processus de production. La matière eut raison de l’idée, la main dépassa l’intellect, et le typographe expérimenté retraça les formes théoriques en matrices physiques qui passèrent pour parfaites. […]

qui en résulta, régi par sa grille de carrés parfaits et approuvé par un grand comité de spécialistes, s’avéra stérile et statique à l’œil. Pris en charge par le graveur de poinçons Philippe Grandjean, les dessins abstraits du caractère royal, à l’usage exclusif de la monarchie, furent subtilement modifiés durant le processus de production. La matière eut raison de l’idée, la main dépassa l’intellect, et le typographe expérimenté retraça les formes théoriques en matrices physiques qui passèrent pour parfaites. […]

Chaque technique offre ses propres possibilités formelles : l’argile et le stylet, le pinceau et l’encre, la plume et le vélin, la gravure dans le plomb ou l’acier, le papier et le crayon, le stylo-bille, la photographie et les appareils photomécaniques, les polices numériques. Malgré tout, le dessin de caractère n’est pas uniquement déterminé par la technique. Les formes des caractères mobiles de Gutenberg provenaient de modèles manuscrits, tout comme la photo composition a imité le dessin de caractères au plomb, et ce malgré l’inéquation de ces modèles préexistants aux médias qui les transposent. Déterminer le vocabulaire formel adapté à une nouvelle technique prend du temps, et faire apparaître l’esthétique propre à chaque médium n’a rien d’évident ou d’immédiat. Quel est le degré de « plombage » d’un caractère au plomb1818 Daniel Berkely Updike, Printing Types: Their History and Use, Cambridge (MA.), Harvard University Press, 1922. ? La qualité esthétique de la photocomposition et sa capacité à produire une forme décorative et picturale, dessinée et fantaisiste devaient être « dé-couvertes1919 Sur la notion de « découverte », voir : Pierre-Damien Huyghe, « Faire franchir un pas à une technique », entretien avec Anthony Masure, Paris, B42/Fork, Back Office, no 1, « Faire avec », 2017, p. 76-84, http://b-o.fr/huyghe (N.D.É.) » : des compositions tellement serrées que les lettres se superposent, des lettrages anamorphosés grâce à un film plié perturbant la lumière qui le traverse, etc. De la même manière, dans le simulacre des médias numériques, où morphing et transformation des images sont monnaie courante, comment définir la base technique d’une esthétique numérique intégrant par exemple les possibilités d’infinie invention et de simulation ou des processus aléatoires introduisant des variations à chaque génération ?

Il est toutefois crucial de ne pas lire les changements de paradigmes historiques uniquement sous l’angle des transformations techniques. En effet, les formes peuvent également être complètement bouleversées par l’évolution des théories. […] Une lettre, comme tout objet culturel, est dessinée en fonction de paradigmes de pensée. Si l’on imagine un glyphe dont la forme évoque une image morale, des éléments cosmologiques ou un roman national, alors les principes de conception qui en régissent la forme priment, quelle qu’en soit la matérialité. De la même manière, la sensibilité moderne du XXe siècle, qui recherchait les potentialités esthétiques au sein des procédés de production, se satisfesait de dessins aux courbes lisses produites par la machine, comme en témoignent les canons de l’Art décoratif. Évidemment, tout moment historique fait toutefois coexister des sensibilités et des conceptions différentes. La modernité de Paul Rand jouxte l’esprit pop de Milton Glaser qui, lui-même, côtoie l’esthétique psychédélique d’un designer graphique comme Victor Moscoso, caractéristique des années 19602020 Steven Heller et Seymour Chwast, Graphic Style: From Victorian to Digital, New York, Harry N. Abrams, 2000.. Un discours unique peut-il englober ces sensibilités aux antipodes ? Sur le plan conceptuel, oui : ces objets traduisent tous la conviction que la pratique singulière et l’invention formelle de chaque designer sont autorisées, voire encouragées, au moment où la culture consumériste explose. Aujourd’hui, l’usage imposé des propriétés discrètes du code alphanumérique nous permet de mettre le système de signes arbitraire au service d’un grand réseau mondial (World Wide Web), dont les racines occidentales se ramifient ainsi jusqu’à l’Antiquité.

Les systèmes de reconnaissance optique des caractères (OCR, Optical Character Recognition) suivent une logique proche  . Les objets imprimés sont analysés en considérant leurs caractères comme des images, reconnues une à une en fonction de leur singularité graphique ; contrairement aux systèmes destinés à « lire » l’écriture manuscrite qui enregistrent l’enchaînement du tracé manuel. Les inventeurs du milieu du XIXe siècle rêvaient déjà de l’OCR, qu’ils imaginaient comme une aide pour les personnes atteintes de déficience visuelle. Il fallut toutefois attendre la deuxième moitié du XXe siècle pour qu’une véritable « machine de lecture » voie le jour. Au départ, les polices étaient conçues en fonction des capacités techniques de la machine, chaque glyphe occupant des zones spécifiques d’une grille sous-jacente. Cela permettait d’attribuer sans ambiguïté une identité unique aux lettres, sans avoir besoin d’un algorithme d’analyse complexe ; la police était essentiellement un code destiné à être lu par les humains et les machines. La sophistication technique permit progressivement de ne plus utiliser de caractères spécifiques à l’OCR, même si certains anciens processus de reconnaissance de motifs perdurent au sein des logiciels contemporains. Ces mécanismes basiques fonctionnent avec des opérations de seuil (séparant les caractères de l’arrière-plan), de segmentation (en symboles séparés), de zonage (divisant le rectangle englobant le glyphe pour que les points, jonctions, lignes ou intersections puissent être analysés de façon optique), d’extraction des singularités et de recherche de correspondances (avec des caractères prédéterminés ou avec un ensemble de singularités formelles). Des problèmes apparaissent lorsque les lettres sont fragmentées, qu’un bruit altère l’image ou que les lettres se superposent ou touchent d’autres éléments visuels ou textuels. La phase d’extraction des singularités formelles des lettres peut être également complétée par un mécanisme d’analyse du langage naturel (natural language processing), qui évalue la probabilité d’occurrence d’un mot en fonction de normes statistiques en renseignant la fréquence d’utilisation ou des règles de syntaxe. Dans le cas de spécimens manuscrits, la simple opération de segmentation pose un problème complexe, la reconnaissance est en effet plus efficace lorsque le programme travaille avec des données intégrant la séquence des tracés qui donne forme aux mots. Ces deux approches de l’OCR correspondent aux différentes conceptions historiques des lettres ; tantôt vues comme des images distinguées par leurs caractéristiques formelles, tantôt perçues comme des tracés issus d’une série de mouvements. […]

. Les objets imprimés sont analysés en considérant leurs caractères comme des images, reconnues une à une en fonction de leur singularité graphique ; contrairement aux systèmes destinés à « lire » l’écriture manuscrite qui enregistrent l’enchaînement du tracé manuel. Les inventeurs du milieu du XIXe siècle rêvaient déjà de l’OCR, qu’ils imaginaient comme une aide pour les personnes atteintes de déficience visuelle. Il fallut toutefois attendre la deuxième moitié du XXe siècle pour qu’une véritable « machine de lecture » voie le jour. Au départ, les polices étaient conçues en fonction des capacités techniques de la machine, chaque glyphe occupant des zones spécifiques d’une grille sous-jacente. Cela permettait d’attribuer sans ambiguïté une identité unique aux lettres, sans avoir besoin d’un algorithme d’analyse complexe ; la police était essentiellement un code destiné à être lu par les humains et les machines. La sophistication technique permit progressivement de ne plus utiliser de caractères spécifiques à l’OCR, même si certains anciens processus de reconnaissance de motifs perdurent au sein des logiciels contemporains. Ces mécanismes basiques fonctionnent avec des opérations de seuil (séparant les caractères de l’arrière-plan), de segmentation (en symboles séparés), de zonage (divisant le rectangle englobant le glyphe pour que les points, jonctions, lignes ou intersections puissent être analysés de façon optique), d’extraction des singularités et de recherche de correspondances (avec des caractères prédéterminés ou avec un ensemble de singularités formelles). Des problèmes apparaissent lorsque les lettres sont fragmentées, qu’un bruit altère l’image ou que les lettres se superposent ou touchent d’autres éléments visuels ou textuels. La phase d’extraction des singularités formelles des lettres peut être également complétée par un mécanisme d’analyse du langage naturel (natural language processing), qui évalue la probabilité d’occurrence d’un mot en fonction de normes statistiques en renseignant la fréquence d’utilisation ou des règles de syntaxe. Dans le cas de spécimens manuscrits, la simple opération de segmentation pose un problème complexe, la reconnaissance est en effet plus efficace lorsque le programme travaille avec des données intégrant la séquence des tracés qui donne forme aux mots. Ces deux approches de l’OCR correspondent aux différentes conceptions historiques des lettres ; tantôt vues comme des images distinguées par leurs caractéristiques formelles, tantôt perçues comme des tracés issus d’une série de mouvements. […]

De façon globale, une lettre peut ainsi être comprise comme une forme ou un modèle préexistant, comme un ductus traduisant une séquence de tracés comprenant des variations de pressions, comme un signe arbitraire, comme une image chargée d’histoire et de références, comme une disposition de vecteurs ou de pixels sur un écran, ou comme un fichier numérique pouvant être manipulé comme une image ou un algorithme. Le phénomène est inverse en termes conceptuels : nous considérons la valeur (numérique, graphique, picturale), la forme (style, histoire, design), la fonctionnalité (précision phonétique, lisibilité), l’authenticité (précision) ou le comportement (fonctionnement) d’une lettre comme fonction de ses origines, c’est-à-dire née des flammes, tracée sur du sable mouillé, marquée par la main de Dieu sur des tablettes de pierre, réduite en image, issue de nulle part ou gravée dans la roche.

« Qu’est-ce qu’une lettre ? » est donc une question tout à fait différente de « Comment est-ce fait ? » Les réponses ne sont jamais synchrones ; les interrogations de base ne proviennent même pas d’un fond commun —, mais se percutent dans un dualisme dynamique. La route qui mène de l’invention des lettres à leur apparition actuelle n’est pas linéaire, mais est une voie de dialogue. Les jalons de cette histoire ne sont pas uniquement un ensemble de dates et d’étiquettes ; création de la plume d’oie, invention de l’impression ou production de la machine à poinçons. Aussi importants que fussent ces développements techniques pour l’évolution des formes matérielles, elles furent néanmoins toujours modifiées au regard de leur schéma conceptuel. Les lettres n’ont pas migré du « A » vers l’écran : en dépit de leur fonctionnement « atomiste », de leur constitution distribuée et de leurs aspects formels, elles ont encore dû être reconstituées et recréées dans leur nouvel environnement ; encore transformables après quatre mille ans d’errance.

Texte intégral initialement publié dans N. Katherine Hayles et Jessica Pressman (dir.), Comparative Textual Media, Minneapolis, University of Minnesota Press, 2013, p. 71-96.