Le traitement et la représentation de données demandent des compétences variées, de la conception visuelle à la programmation en passant par la statistique et le design d’interaction. Comment transmettre ces expertises diverses dans des formations toujours plus spécialisées ? Sandra Chamaret et Loïc Horellou, enseignants à la Haute école d’arts du Rhin (HEAR), dressent ici un panorama de contextes d’enseignement singuliers, à même de sensibiliser les étudiants aux enjeux d’un champ protéiforme.

Écoles et archives

En 2017, Douglas Edric Stanley et Cassandre Poirier-Simon, deux enseignants du cours de design algorithmique de la Haute école d’art et de design (HEAD) de Genève, mènent, avec le Bodmer lab, un laboratoire de l’Université de Genève, un workshop basé sur une partie du fonds documentaire de la fondation Bodmer. Cette institution privée abrite un musée et une bibliothèque constituée à partir de la collection du bibliophile Martin Bodmer (1899-1971) rassemblant plus de 150 000 pièces (manuscrits précieux, éditions originales, etc.). L’objectif du workshop d’une semaine est d’expérimenter de nouveaux usages du fonds en mettant en place des méthodes de travail novatrices. Trois étudiants du groupe 11 Mathilde Buenerd, Nicolas Baldran et David Héritier. choisissent de travailler à partir d’un corpus de plusieurs centaines d’éditions de Faust, écrit par Goethe en 1808 22 Ce fameux récit décrit les tourments d’Heinrich Faust, un homme de sciences érudit qui, à la fin de sa vie, constate que toutes ses connaissances ne peuvent pas lui permettre de comprendre profondément le monde et qu’il est incapable de profiter de la vie. Il promet alors son âme au diable si ce dernier le libère de son insatisfaction..

Leur projet, Ultimate Faust  , consiste en la création d’un générateur et d’une série de scripts (Photoshop et Processing) permettant d’extraire les éléments paratextuels (les notes, les chiffres, la décoration, le format de la page, ou encore les artefacts des scanners) issus d’une vingtaine d’éditions de Faust (en ourdou, en allemand, ou dans d’autres langues où seuls les numéros de chapitre ont été conservés). Les données de base, constituées d’un ensemble d’images en très haute définition, sont ensuite fusionnées afin de produire une nouvelle publication hybride, constituant une pièce unique parmi tous les multiples possibles et compilant des éléments extraits des éditions originales, fac-similés dans leur contexte initial (un détail de la page 28 d’un ouvrage source sera imprimé au même emplacement de la page 28 du livre synthèse). Le projet met en jeu les notions de multiple et d’exemplaire unique en faisant dialoguer des éditions différentes, télescopant ainsi les époques, les lieux, les langues et agissant comme une mise en abyme de l’utopie de la connaissance universelle. Ce livre unique veut incarner toutes les éditions précédentes de Faust et intégrera le fonds Bodmer, comme ses prédécesseurs.

, consiste en la création d’un générateur et d’une série de scripts (Photoshop et Processing) permettant d’extraire les éléments paratextuels (les notes, les chiffres, la décoration, le format de la page, ou encore les artefacts des scanners) issus d’une vingtaine d’éditions de Faust (en ourdou, en allemand, ou dans d’autres langues où seuls les numéros de chapitre ont été conservés). Les données de base, constituées d’un ensemble d’images en très haute définition, sont ensuite fusionnées afin de produire une nouvelle publication hybride, constituant une pièce unique parmi tous les multiples possibles et compilant des éléments extraits des éditions originales, fac-similés dans leur contexte initial (un détail de la page 28 d’un ouvrage source sera imprimé au même emplacement de la page 28 du livre synthèse). Le projet met en jeu les notions de multiple et d’exemplaire unique en faisant dialoguer des éditions différentes, télescopant ainsi les époques, les lieux, les langues et agissant comme une mise en abyme de l’utopie de la connaissance universelle. Ce livre unique veut incarner toutes les éditions précédentes de Faust et intégrera le fonds Bodmer, comme ses prédécesseurs.

Les éléments paratextuels sont ici assimilés à des métadonnées. Depuis quelques années, dans les grands systèmes informatiques, les métadonnées et leurs interconnexions sont devenues plus importantes que les données elles-mêmes. C’est à partir des métadonnées que le monde dans lequel nous vivons est modélisé et ce sont ces informations que les ordinateurs sont capables d’exploiter pour appréhender les relations entre humains ou avec les machines. La collecte et l’exploitation des métadonnées sont donc des enjeux centraux pour toute organisation ayant à traiter une archive.

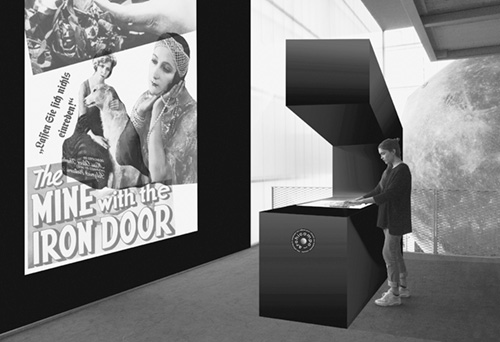

Un autre projet pédagogique  , mené à l’automne 2017 par Marina Wainer (Master 2 INA Patrimoines Audiovisuels) et Florence Jamet-Pinkiewicz (DSAA 1 Design et Création numérique, école Estienne), part précisément des métadonnées comme ressort pour parcourir la collection patrimoniale du Centre national du cinéma. Le CNC conserve et gère les archives françaises du film, une multitude de collections composées de documents argentiques (négatifs, copies, phases de travail et de montage, supports nitrate des années 1910, etc.), témoignant d’environ 150 000 films. La période de collecte, très vaste, s’étend du cinéma primitif jusqu’à nos jours et se trouve répertoriée au sein d’une base de données (et de métadonnées) partagée avec plusieurs cinémathèques régionales. Au-delà des films en eux-mêmes, toutes sortes de matériaux cinéma-tographiques sont rassemblés dans ces bases : bandes-annonces, essais d’acteurs, scènes coupées, rushes, documentaires techniques, films scientifiques, films familiaux, etc. Toutes les informations décrivant ces films, notamment pour les identifier puis les inventorier, s’entendent alors comme métadonnées : mots-clés résumant le contenu du film, éléments cachés (logotype de la société de production, marques, etc.), collages spécifiques de la pellicule 33 Voir la présentation de Claude Mussou et Nicolas Hervé, (INA), lors de la soirée di/zaïn #5 : code(s)+data(s) le 26 février 2012, http://b-o.fr/dizain, etc. Celles-ci sont produites et détenues en propre par le CNC, alors que les films restent pour la plupart en dépôt légal ou volontaire, c’est-à-dire que leurs supports physiques appartiennent à une personne (physique ou morale) et que leur diffusion est soumise au droit d’auteur ou dépend du domaine public.

, mené à l’automne 2017 par Marina Wainer (Master 2 INA Patrimoines Audiovisuels) et Florence Jamet-Pinkiewicz (DSAA 1 Design et Création numérique, école Estienne), part précisément des métadonnées comme ressort pour parcourir la collection patrimoniale du Centre national du cinéma. Le CNC conserve et gère les archives françaises du film, une multitude de collections composées de documents argentiques (négatifs, copies, phases de travail et de montage, supports nitrate des années 1910, etc.), témoignant d’environ 150 000 films. La période de collecte, très vaste, s’étend du cinéma primitif jusqu’à nos jours et se trouve répertoriée au sein d’une base de données (et de métadonnées) partagée avec plusieurs cinémathèques régionales. Au-delà des films en eux-mêmes, toutes sortes de matériaux cinéma-tographiques sont rassemblés dans ces bases : bandes-annonces, essais d’acteurs, scènes coupées, rushes, documentaires techniques, films scientifiques, films familiaux, etc. Toutes les informations décrivant ces films, notamment pour les identifier puis les inventorier, s’entendent alors comme métadonnées : mots-clés résumant le contenu du film, éléments cachés (logotype de la société de production, marques, etc.), collages spécifiques de la pellicule 33 Voir la présentation de Claude Mussou et Nicolas Hervé, (INA), lors de la soirée di/zaïn #5 : code(s)+data(s) le 26 février 2012, http://b-o.fr/dizain, etc. Celles-ci sont produites et détenues en propre par le CNC, alors que les films restent pour la plupart en dépôt légal ou volontaire, c’est-à-dire que leurs supports physiques appartiennent à une personne (physique ou morale) et que leur diffusion est soumise au droit d’auteur ou dépend du domaine public.

Le sujet proposé aux étudiants consiste à inventer un dispositif de consultation, visuel et dynamique, sur écran ou dans l’espace physique. Le projet Archicompo se compose de plusieurs objets interactifs installés au cinéma George Méliès à Montreuil. Les visiteurs disposent d’images extraites de films muets, imprimées sur rhodoïd (matériau qui évoque la bobine de film), avec lesquelles ils construisent des affiches de films fictives, déposées sur l’écran d’un vidéoprojecteur pour une visualisation collective. Dans un second temps, un programme intégrant un algorithme de reconnaissance d’image compose un scénario fictif à partir de l’affiche et crée un film au montage inédit, chaque image renvoyant à une portion de scénario. Ce détournement des données évoque le montage des films forains.

Ces deux exemples, Bodmer Lab/HEAD et CNC/Estienne, révèlent l’intérêt porté par certaines institutions patrimoniales à créer un partenariat avec des écoles d’art. Dans ce type de collaboration, le fonds, conséquent, est ranimé par les fouilles estudiantines et le projet pédagogique porte un œil rafraîchissant sur les collections. De son côté, l’école a accès à des données vastes, parfois déjà repérées et organisées suivant un cahier des charges préétabli.

Livres et programmes

Ce type d’atelier est également l’occasion de perturber les habitudes des étudiants afin de les forcer à se questionner sur leurs méthodes de travail. Dans le cas du design éditorial imprimé, le processus d’élaboration des projets est souvent balisé : le contenu doit être préparé et rassemblé, mis en forme dans un logiciel de mise en page souvent identique, puis imprimé. Peu d’étudiants envisagent que la conception d’un livre puisse se programmer et être automatisée. Cette automatisation implique en effet d’autres manières de faire où les designers doivent accepter de ne plus mettre en forme leurs documents manuellement. La conception procédurale se rapproche plus de méthodes issues de la mise en page Web où la structure du contenu prime sur sa forme. Comme pour les métadonnées des images sur les réseaux, c’est la sémantique du texte qui devient centrale et même si les designers sont toujours responsables de la forme finale, ils adoptent de plus en plus un rôle d’architecte des contenus.

On observe actuellement une réelle volonté d’interroger les processus de création visuelle, notamment parce que les quantités de contenu à gérer ne sont plus compatibles avec les méthodologies conventionnelles. Ainsi, le groupe de recherche PrePostPrint 44 Le salon de l’édition alternative, organisé par PrePostPrint à la Gaîté lyrique (Paris) le 21 octobre 2017, présentait des initiatives manipulant divers modes de publications : génératifs, contributifs, open source, etc. Voir le site Web prepostprint.org et le journal Code x 01 (design Julie Blanc, éditions HYX), qui documente ce salon à la façon d’un catalogue. défend depuis 2017 une approche de la publication expérimentale, où un même contenu formaté avec les langages du Web (HTML/XML) est susceptible d’être publié sous différentes plateformes et différents formats. PrePostPrint associe des designers graphiques qui expérimentent ce type de processus pour envisager une autre manière de concevoir les objets imprimés.

Depuis 2015 55 2015 : leWeb.imprimer(), un site Web devait être choisi afin d’en produire une édition, générée à partir du code source et des images issus de l’aspiration du site. 2016 : data.print(), une édition devait être générée à partir d’une extraction des notices bibliographiques issues d’un corpus d’ouvrages des collections des médiathèques de la ville de Strasbourg. 2017 : mon catalogue, où il fallait réfléchir de manière générale à la notion de catalogue., l’atelier de communication graphique de la Haute école des arts du Rhin (HEAR), propose ainsi un cours de publication procédurale

reposant sur la mise en place d’algorithmes destinés au traitement de contenus et à la mise en forme de jeux de données importants. Pour chaque projet, la première étape de travail consiste à extraire (scrapping) des données brutes issues de sites Web, de bases de données ou de tableaux au format CSV par exemple. Cette première phase, difficile à réaliser manuellement du fait de la quantité d’éléments (plusieurs milliers), nécessite l’usage d’outils spécifiques (en particulier des aspirateurs de sites) ou de programmes créés pour l’occasion (avec les langages PHP, JavaScript ou Python).

reposant sur la mise en place d’algorithmes destinés au traitement de contenus et à la mise en forme de jeux de données importants. Pour chaque projet, la première étape de travail consiste à extraire (scrapping) des données brutes issues de sites Web, de bases de données ou de tableaux au format CSV par exemple. Cette première phase, difficile à réaliser manuellement du fait de la quantité d’éléments (plusieurs milliers), nécessite l’usage d’outils spécifiques (en particulier des aspirateurs de sites) ou de programmes créés pour l’occasion (avec les langages PHP, JavaScript ou Python).

La seconde étape consiste à traiter ces informations, à les classer, à les filtrer et à les exporter dans un format XML, permettant de préciser la structure de contenu indépendamment de la forme finale. Les images sont redimensionnées, recadrées et optimisées avec des programmes automatisables comme ImageMagick (1990) suivant les normes d’usage en prépresse. La création de la maquette n’intervient qu’après cette chaîne d’opération et consiste à définir un ensemble de règles de mise en forme à partir des données formatées. L’application de ces règles aux données de base constitue la maquette à proprement parler. Des styles automatiques sont intégrés en fonction du balisage des données ou grâce à des expressions régulières permettant de détecter des récurrences textuelles. Finalement, ce n’est qu’à la marge que certaines opérations manuelles sont réalisées.

Données quantifiées et capteurs

La notion de donnée quantifiée existe depuis les débuts de l’écriture (la naissance des chiffres et des lettres est liée à l’émergence de l’agriculture et à la sédentarisation, notamment pour compter les récoltes, les surfaces cultivables, etc.), mais l’émergence des big data, conséquence du développement rapide du Web au début des années 2000.

Ces problématiques s’accélèrent encore avec l’apparition de ce que l’on nomme l’Internet des objets. Fin mars 2016, le studio Chevalvert mène le workshop DataFossil 88 DataFossil : 29, 30 et 31 mars 2016, mené par Stéphane Buellet et Julia Puyo, http://b-o.fr/datafossil  à l’espace Stéréolux (Nantes) avec différents participants dont des étudiants en DSAA design graphique à Marseille, proposant de travailler avec des données issues de capteurs divers et de produire des objets tangibles matérialisant ces informations. Les données manipulées sont similaires à ce que captent nos objets du quotidien : informations de luminosité, de pression, de flexion, fréquence cardiaque, etc. Les participants sont ensuite invités à produire différents artefacts en volumes, semblables à des fossiles de la civilisation du tout numérique.

à l’espace Stéréolux (Nantes) avec différents participants dont des étudiants en DSAA design graphique à Marseille, proposant de travailler avec des données issues de capteurs divers et de produire des objets tangibles matérialisant ces informations. Les données manipulées sont similaires à ce que captent nos objets du quotidien : informations de luminosité, de pression, de flexion, fréquence cardiaque, etc. Les participants sont ensuite invités à produire différents artefacts en volumes, semblables à des fossiles de la civilisation du tout numérique.

La multiplication des données est une conséquence directe du développement des capteurs connectés, des logiciels de pistage sur le Web ou des échanges de bases de données de clientèle. L’enseignement se doit de maintenir un regard critique fort chez les étudiants sur la vie dans une société numérique, sur la production et la diffusion des données personnelles, sur les usages professionnels liés aux médias sociaux, sur la réappropriation des données publiques (data.gouv) ou rendues publiques (Panama et Paradise Papers). Dans le cas d’étudiants en art et en design, ce rapport critique passe principalement par la forme visuelle, par un contenu brut à mettre en forme et à investir.

Designers et journalistes

Les principaux acteurs des données sont les ingénieurs, les informaticiens, mais aussi les chercheurs qui manipulent et visualisent des quantités importantes de données pour comprendre et avancer dans leurs hypothèses et leurs recherches (historiques, sociales, médicales, etc.) 99 Voir : Olaf Avenati et Pierre-Antoine Chardel (dir.), Datalogie. Formes et imaginaires du numérique, Paris, éditions Loco, 2016.. Les diagrammes, histogrammes et autres camemberts sont des représentations visuelles inventées par des économistes, des infirmières, des épidémiologistes, des statisticiens ou des géographes pour expliquer leur démarche scientifique et appuyer leurs démonstrations. À l’origine, il ne s’agit pas de formes créées par des designers. Aujourd’hui, la visualisation de données croise plusieurs pratiques et les rôles de chacun sont flous, tout se mélange : les ingénieurs prennent des décisions quant à la mise en forme de leurs mesures, les designers graphiques mènent l’enquête, tandis que les journalistes apprennent à programmer. Pour compliquer la situation, le développement rapide de l’apprentissage profond (deep learning) remet parallèlement en cause une partie des métiers émergents liés à l’analyse des données. Reste que de nombreux métiers seront à pourvoir dans les années qui viennent et que ces derniers demanderont certainement d’excellentes capacités de travail en équipe.

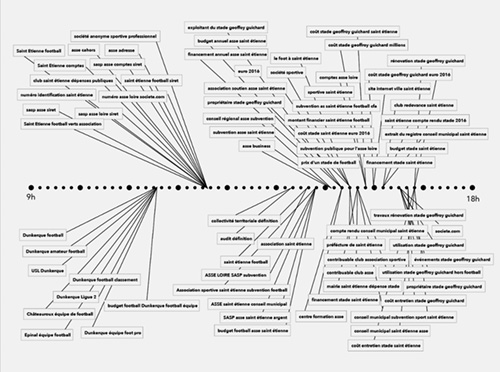

Le croisement des disciplines est d’ailleurs le sujet central d’un workshop  mené par le journaliste de données Nicolas Kayser-Bril 1212 Responsable des datavisualisations au sein de feu l’équipe éditoriale du pure player www.owni.fr (2009–2011). dans l’atelier de didactique visuelle de la HEAR (Strasbourg). En arrivant, la première question qu’il pose aux étudiants est : « Êtes-vous familiers des tableurs ? » A priori, en école d’art, l’usage de logiciels comme Excel (1985) ne fait pas partie des habitudes. Durant trois jours, les quinze étudiants, designers graphiques ou illustrateurs, enquêtent sur le financement des clubs de football français : fouiller la presse locale, lire et analyser les rapports d’activités accessibles, vérifier les sources disponibles, en déduire les sources manquantes, récolter, croiser, téléphoner pour tenter de joindre un responsable associatif ou politique, organiser les données chiffrées dans un tableau à double entrée, etc. Ils découvrent des méthodes d’investigation et de vérification de l’information propres au journalisme, avec les outils en usage dans la profession. Certains se prennent au jeu, mais la majorité est soulagée lorsqu’il s’agit de mettre en forme ce qu’ils ont trouvé. Si le journaliste invité est d’abord surpris par la ténacité avec laquelle ils dénichent des informations, il est surtout étonné par la facilité avec laquelle ils articulent immédiatement les représentations visuelles. Même en apprenant et en s’immisçant dans des démarches autres, chacun reste pétri de sa dominante professionnelle.

mené par le journaliste de données Nicolas Kayser-Bril 1212 Responsable des datavisualisations au sein de feu l’équipe éditoriale du pure player www.owni.fr (2009–2011). dans l’atelier de didactique visuelle de la HEAR (Strasbourg). En arrivant, la première question qu’il pose aux étudiants est : « Êtes-vous familiers des tableurs ? » A priori, en école d’art, l’usage de logiciels comme Excel (1985) ne fait pas partie des habitudes. Durant trois jours, les quinze étudiants, designers graphiques ou illustrateurs, enquêtent sur le financement des clubs de football français : fouiller la presse locale, lire et analyser les rapports d’activités accessibles, vérifier les sources disponibles, en déduire les sources manquantes, récolter, croiser, téléphoner pour tenter de joindre un responsable associatif ou politique, organiser les données chiffrées dans un tableau à double entrée, etc. Ils découvrent des méthodes d’investigation et de vérification de l’information propres au journalisme, avec les outils en usage dans la profession. Certains se prennent au jeu, mais la majorité est soulagée lorsqu’il s’agit de mettre en forme ce qu’ils ont trouvé. Si le journaliste invité est d’abord surpris par la ténacité avec laquelle ils dénichent des informations, il est surtout étonné par la facilité avec laquelle ils articulent immédiatement les représentations visuelles. Même en apprenant et en s’immisçant dans des démarches autres, chacun reste pétri de sa dominante professionnelle.

Ce fonctionnement, singulier dans le contexte d’une école d’art, est un modèle plus répandu dans le champ du journalisme. Des initiatives comme le DDJCamp (Data Driven Journalism Camp) 1313 Organisé par Nika Aleksejeva, Martin Maska et Anastasia Valeeva, voir : http://b-o.fr/ddjcamp, un évènement organisé à Berlin en novembre 2016 par le club de la jeune presse européenne (Youthpress), en témoignent. Ce workshop de huit jours rassemble une trentaine de personnes, majoritairement des jeunes journalistes, des développeurs et quelques designers graphiques (de l’École supérieure d’art de Cambrai notamment). L’objectif est d’interroger la manière dont est traitée la question des réfugiés à l’échelle européenne et de produire des articles publiés en partenariat avec des organes de presse européens. Le processus de travail suit la méthodologie employée par le Consortium international des journalistes d’investigation (ICIJ 1414 Le Consortium inter-national des journalistes d’investigation est un regroupement de journalistes de différents organes de presse de 70 pays qui travaillent en équipe sur des enquêtes mettant en jeu de très grandes quantités de données avec des ramifications inter-nationales, nécessitant une collaboration au regard de la complexité des sujets à traiter. Voir : https://www.icij.org) pour le traitement d’affaires comme les Panama Papers ou les Paradise Papers : définition d’un angle de traitement du sujet, identification des ressources possibles, récupération, traitement et nettoyage des données, analyse, rédaction et restitution ; chaque étape est associée à l’intervention d’un spécialiste. L’observation attentive de ce processus révèle que la phase de visualisation peut intervenir à différentes étapes du travail et opérer, par exemple, comme aide à l’analyse (lorsque les données sont si nombreuses qu’il est difficile de faire émerger des anomalies autrement que par l’image), ou comme représentation finale pour le lecteur. Les graphistes interviennent ici dès le début des recherches et non en phase finale, pour l’« enrobage visuel », comme c’est malheureusement souvent le cas.

Les équipes doivent être capables de mener des enquêtes indépendantes basées sur la récolte de données liées aux problèmes de migration dans différents contextes nationaux en Europe et de valoriser les compétences complémentaires de chacun des membres. L’objectif sous-jacent est surtout d’introduire et de conforter le statut de journaliste de données dans les rédactions européennes. Si ce programme est composite en termes de disciplines mobilisées, il est homogène dans le thème sociétal abordé qui s’inscrit dans une démarche de formation continue destinée aux professionnels du journalisme. Ce public, plus sensibilisé et opérationnel que les étudiants designers, a la capacité d’aboutir à un résultat en une semaine ; les reportages produits durant le workshop sont ainsi publiés tels quels dans la presse internationale (Danemark, Italie, Monténégro, Allemagne, etc.). Même si la qualité visuelle des productions est discutable, ce processus mérite d’être salué : en partageant leurs méthodologies de travail, les intervenants aux profils multiples ont réussi à fédérer un ensemble de participants autour de nouvelles pratiques en se confrontant directement à un contexte réel. Comme pour les journalistes il y a quelque temps, nul doute que la sensibilisation progressive des designers aux questions liées au traitement des données permettra d’aboutir à des résultats d’ampleur et de qualité dans les années à venir.