Si des fac-similés mis à disposition sur des plateformes en ligne comme Gallica ou Project Gutenberg sont parfois associés à des documents textes issus d’une reconnaissance automatique de contenus textes (OCR), ces derniers sont détachés de leur forme typographique initiale. Partant du constat que les technologies actuelles de numérisation d’ouvrages anciens dissocient le contenu de la forme, le projet Re-typographe 11 http://b-o.fr/retypographe a pour ambition de créer un programme informatique capable de vectoriser dynamiquement la typographie d’ouvrages de la Renaissance. Re-typographe est mené depuis 2013 par l’ANRT Nancy 22 Atelier national de recherche typographique. en partenariat avec le LORIA 33 Laboratoire lorrain de recherche en informatique et ses applications.. Coordonné par Thomas Huot-Marchand et Bart Lamiroy, il a d’abord été pris en charge par Thomas Bouville en 2013-2014, puis par David Vallance pour l’année 2014-2015. Cet article fait état des premières recherches concernant la reconstitution et la numérisation des caractères utilisés, aspect qui recèle les enjeux les plus complexes.

Quelle distance adopter ?

Retranscrire une forme typographique ancienne pour la rendre disponible dans un standard technologique actuel est une pratique courante dans le domaine du dessin de caractères. Hommage, restauration, résurrection, adaptation, imitation, re-interprétation sont autant de niveaux de proximités possibles par rapport à l’original 44 John Downer dresse une typologie des postures que peuvent entretenir les designers avec les sources historiques dans le spécimen du caractère Tribute (fonderie Emigre), voir : John Downer, « Call It What It Is », Introducing « Tribute » ;a family of 8 fonts by Frank Heine, released by Emigre Fonts, Sacramento, Emigre, 2003. qui influencent la nouvelle production. Dans tous ces cas, l’exercice est nécessairement teinté d’un fort niveau de subjectivité de la part de l’interprète . Dans Re-typographe, la reconstitution respecte la topographie du texte (ses éléments visuels et leurs emplacements), et l’absence de certains glyphes (k, w, @, etc.) dans les alphabets d’époque, tandis que les imperfections de l’impression au plomb sont supprimées.

. Dans Re-typographe, la reconstitution respecte la topographie du texte (ses éléments visuels et leurs emplacements), et l’absence de certains glyphes (k, w, @, etc.) dans les alphabets d’époque, tandis que les imperfections de l’impression au plomb sont supprimées.

Si ce contexte de travail balise déjà la distance que doit entretenir le résultat du programme avec la source, celle-ci reste tout de même relative. Que considère-t-on comme « imperfections » ? Que faire des écarts d’encrages entre les lignes ? Comment gérer les lettres mal imprimées ou dont le poinçon était cassé ? Ces questions ont été explorées suivant deux méthodes de numérisation des caractères ayant chacune comme base un regroupement des caractères similaires par proximité formelle.

Affiner une silhouette

La première méthode consiste à calculer la forme moyenne des images bitmap de chacun de ces groupes de lettres. Le résultat propose une image stable, dépouillée des variations inhérentes au procédé d’impression, mais les formes obtenues ont le défaut de présenter un aspect érodé. Cette approche, admettant de ne pas aller plus loin que l’original imprimé, donne également lieu à des jonctions de courbes au fût trop grasses ou à des contre-formes « bouchées » lorsque ces altérations sont présentes dans le document analysé. Quels seraient les mécanismes permettant d’affiner ce résultat ? Comment peut-on produire une forme moyenne plus pertinente ? Quels types d’échantillons privilégier ? Quelle méthode de calcul serait la plus appropriée ?

Serait-il judicieux de regrouper les occurrences des lettres avant d’en faire la moyenne ?

Déterminer des modèles paramétriques

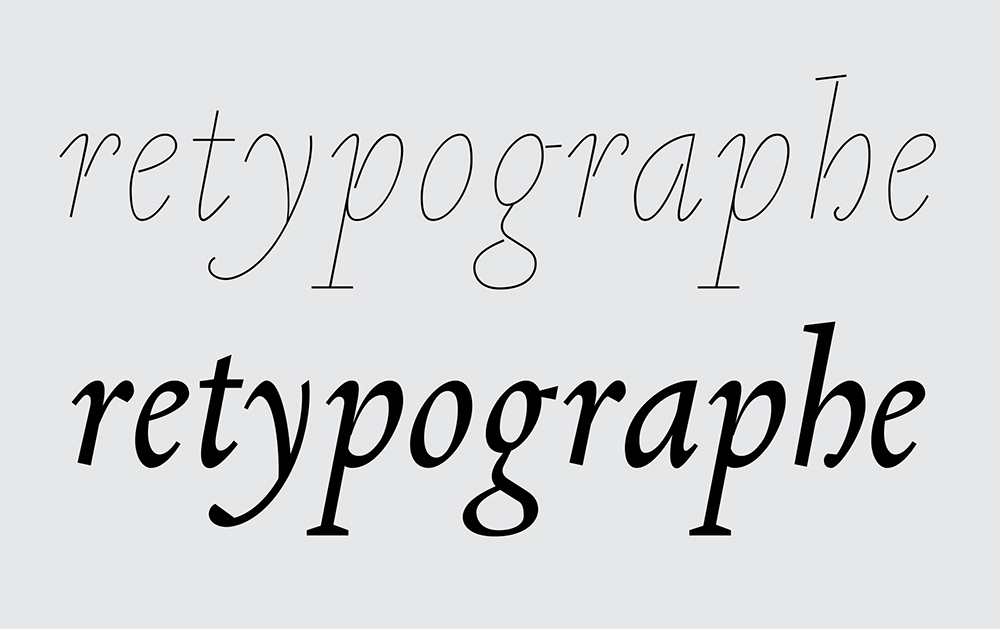

La seconde méthode s’est orientée vers une réinterprétation du caractère original basée sur la détection d’un squelette générique auquel s’applique un ensemble de paramètres formels (graisse, contraste, hauteur de capitales, etc.). Elle permet de s’émanciper des problèmes liés à l’impression et à l’usure des plombs, mais nécessite d’accepter une certaine simplification des formes. La fidélité aux détails du caractère d’origine est mise en retrait à la faveur d’une cohérence d’ensemble. Toutefois, un squelette normalisé et paramétré peut-il réellement reproduire des formes de la Renaissance ? Quel est le niveau de perte acceptable ? Jusqu’où peut-on établir des relations entre différents éléments formels qui composent un alphabet ?

auquel s’applique un ensemble de paramètres formels (graisse, contraste, hauteur de capitales, etc.). Elle permet de s’émanciper des problèmes liés à l’impression et à l’usure des plombs, mais nécessite d’accepter une certaine simplification des formes. La fidélité aux détails du caractère d’origine est mise en retrait à la faveur d’une cohérence d’ensemble. Toutefois, un squelette normalisé et paramétré peut-il réellement reproduire des formes de la Renaissance ? Quel est le niveau de perte acceptable ? Jusqu’où peut-on établir des relations entre différents éléments formels qui composent un alphabet ?

L’œil de la machine

En typographie, l’œil (humain) est souvent le dernier juge. Comment alors définir avec des mots le résultat que l’on attend d’un programme de génération de caractères ? Existe-t-il des critères objectifs d’une « bonne » forme typographique ? Quels protocoles mettre en place pour permettre d’évaluer la pertinence des différentes directions exposées ici ? Comment doter un programme numérique d’informations d’ordre historique et culturel ?

Les recherches typographiques et techniques menées dans le cadre de Re-typographe ont fait émerger des amorces de réponses à ces questions qui furent assemblées pour constituer un prototype fonctionnel du programme. Cette première version constitue une étape importante dont l’usage ne manquera pas d’apporter de nouveaux éclairages aux interrogations actuelles et d’en soulever de nouvelles.